1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

125

126

127

128

129

130

131

132

133

134

135

136

137

138

139

140

141

142

143

144

145

146

147

148

149

150

151

152

153

154

155

156

157

158

159

160

161

162

163

164

165

166

167

168

169

170

171

172

173

174

175

176

177

178

179

180

181

182

183

184

185

186

187

188

189

190

191

192

193

194

195

196

197

198

199

200

201

202

203

204

205

206

207

208

209

210

211

212

213

214

215

216

217

218

219

220

221

222

223

224

225

226

227

228

229

230

231

232

233

234

235

236

237

238

239

240

241

242

243

244

245

246

247

248

249

250

251

252

253

254

255

256

257

258

259

260

261

262

263

264

265

266

267

268

269

270

271

272

273

274

275

276

277

278

279

280

281

282

283

284

285

286

287

288

289

290

291

292

293

294

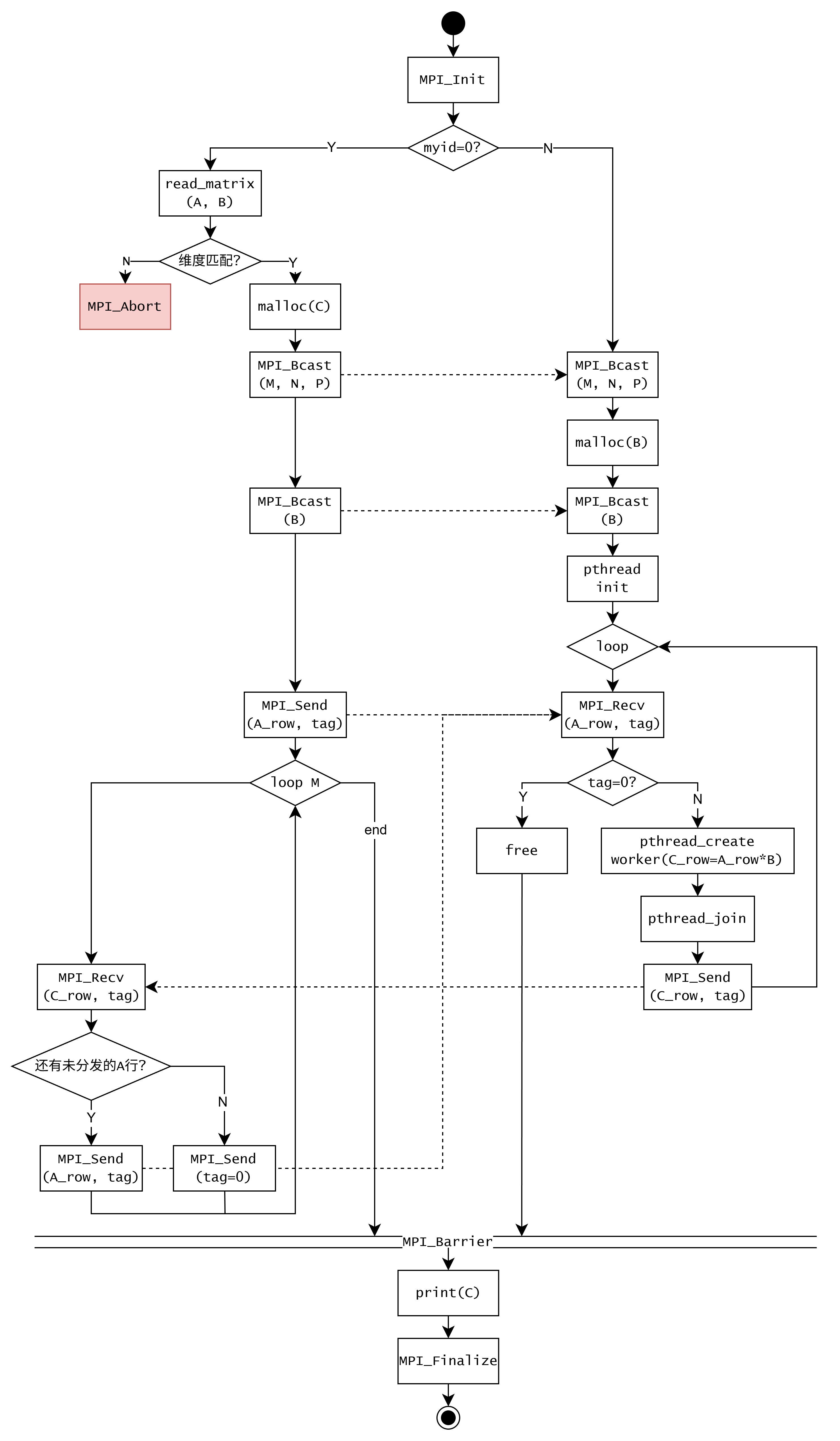

| #include <stdio.h>

#include <mpi.h>

#include <sys/sysinfo.h>

#include <pthread.h>

#include <stdlib.h>

struct threadArg {

int tid;

float* B;

int N_dim;

int P_dim;

float* A_row;

float* C_row;

int numthreads;

};

struct threadArg* targs;

void* worker(void* arg) {

int i, j;

struct threadArg* myarg = (struct threadArg*)arg;

int N = myarg->N_dim;

int P = myarg->P_dim;

for (i = myarg->tid; i < P; i += myarg->numthreads) {

myarg->C_row[i] = 0.0;

for (j = 0; j < N; j++) {

myarg->C_row[i] += myarg->A_row[j] * myarg->B[j * P + i];

}

}

return NULL;

}

int read_matrix(const char* filename, int* rows, int* cols, float** matrix_ptr) {

FILE* file = fopen(filename, "rb");

if (!file) {

printf("错误: 无法打开文件 %s\n", filename);

return 0;

}

int m, n;

int i;

fread(&m, sizeof(int), 1, file);

fread(&n, sizeof(int), 1, file);

*rows = m;

*cols = n;

double* temp_matrix = (double*)malloc(m * n * sizeof(double));

if (!temp_matrix) {

printf("错误: 为double矩阵分配临时内存失败。\n");

fclose(file);

return 0;

}

*matrix_ptr = (float*)malloc(m * n * sizeof(float));

if (!(*matrix_ptr)) {

printf("错误: 为float矩阵分配内存失败。\n");

free(temp_matrix);

fclose(file);

return 0;

}

fread(temp_matrix, sizeof(double), m * n, file);

fclose(file);

for (i = 0; i < m * n; i++) {

(*matrix_ptr)[i] = (float)temp_matrix[i];

}

free(temp_matrix);

return 1;

}

int main(int argc, char *argv[]) {

int myid, numprocs;

MPI_Status status;

int i, j, k, numsend, sender;

int numthreads;

int M, N, P;

float *A = NULL, *B = NULL, *C = NULL;

pthread_t* tids;

float *A_row, *C_row;

MPI_Init(&argc, &argv);

MPI_Comm_rank(MPI_COMM_WORLD, &myid);

MPI_Comm_size(MPI_COMM_WORLD, &numprocs);

if (myid == 0) {

const char* filename_A = "matrix_A.dat";

const char* filename_B = "matrix_B.dat";

int N_A, N_B;

if (!read_matrix(filename_A, &M, &N_A, &A)) {

MPI_Abort(MPI_COMM_WORLD, 1);

}

if (!read_matrix(filename_B, &N_B, &P, &B)) {

free(A);

MPI_Abort(MPI_COMM_WORLD, 1);

}

if (N_A != N_B) {

printf("错误: 矩阵维度不匹配. A是 %dx%d, B是 %dx%d.\n", M, N_A, N_B, P);

free(A);

free(B);

MPI_Abort(MPI_COMM_WORLD, 1);

}

N = N_A;

printf("矩阵A: %d x %d, 矩阵B: %d x %d\n", M, N, N, P);

C = (float*)malloc(M * P * sizeof(float));

if (!C) {

printf("错误: 为结果矩阵C分配内存失败。\n");

free(A); free(B);

MPI_Abort(MPI_COMM_WORLD, 1);

}

}

int dims[3];

if (myid == 0) {

dims[0] = M;

dims[1] = N;

dims[2] = P;

}

MPI_Bcast(dims, 3, MPI_INT, 0, MPI_COMM_WORLD);

if (myid != 0) {

M = dims[0];

N = dims[1];

P = dims[2];

}

if (myid != 0) {

B = (float*)malloc(N * P * sizeof(float));

}

MPI_Bcast(B, N * P, MPI_FLOAT, 0, MPI_COMM_WORLD);

if (!myid) {

j = (numprocs - 1) < M ? (numprocs - 1) : M;

for (i = 1; i <= j; i++) {

MPI_Send(A + (i-1)*N, N, MPI_FLOAT, i, i, MPI_COMM_WORLD);

}

numsend = j;

for (i = j + 1; i < numprocs; i++) {

MPI_Send(A, N, MPI_FLOAT, i, 0, MPI_COMM_WORLD);

}

for (i = 1; i <= M; i++) {

float result[P];

MPI_Recv(result, P, MPI_FLOAT, MPI_ANY_SOURCE, MPI_ANY_TAG, MPI_COMM_WORLD, &status);

sender = status.MPI_SOURCE;

int index = status.MPI_TAG - 1;

if (index >= 0 && index < M) {

for (k = 0; k < P; k++) {

C[index*P + k] = result[k];

}

}

if (numsend < M) {

MPI_Send(A + numsend*N, N, MPI_FLOAT, sender, numsend + 1, MPI_COMM_WORLD);

numsend++;

} else {

MPI_Send(A, N, MPI_FLOAT, sender, 0, MPI_COMM_WORLD);

}

}

} else {

numthreads = get_nprocs();

tids = (pthread_t*)malloc(numthreads * sizeof(pthread_t));

A_row = (float*)malloc(N * sizeof(float));

C_row = (float*)malloc(P * sizeof(float));

targs = (struct threadArg*)malloc(numthreads * sizeof(struct threadArg));

for (i = 0; i < numthreads; i++) {

targs[i].tid = i;

targs[i].B = B;

targs[i].N_dim = N;

targs[i].P_dim = P;

targs[i].A_row = A_row;

targs[i].C_row = C_row;

targs[i].numthreads = numthreads;

}

while (1) {

MPI_Recv(A_row, N, MPI_FLOAT, 0, MPI_ANY_TAG, MPI_COMM_WORLD, &status);

if (status.MPI_TAG == 0) {

break;

}

int index_tag = status.MPI_TAG;

for (i = 0; i < numthreads; i++) {

pthread_create(&tids[i], NULL, worker, &targs[i]);

}

for (i = 0; i < numthreads; i++) {

pthread_join(tids[i], NULL);

}

MPI_Send(C_row, P, MPI_FLOAT, 0, index_tag, MPI_COMM_WORLD);

}

free(B); free(tids); free(A_row); free(C_row); free(targs);

}

MPI_Barrier(MPI_COMM_WORLD);

if (!myid) {

printf("结果矩阵 C:\n");

for (i = 0; i < M; i++) {

for (j = 0; j < P; j++) {

printf("%6.2f ", C[i*P + j]);

}

printf("\n");

}

free(A); free(B); free(C);

}

MPI_Finalize();

return 0;

}

|